Bratislavská kongresová sála bola zaplnená a čakala hviezdnu rečníčku.

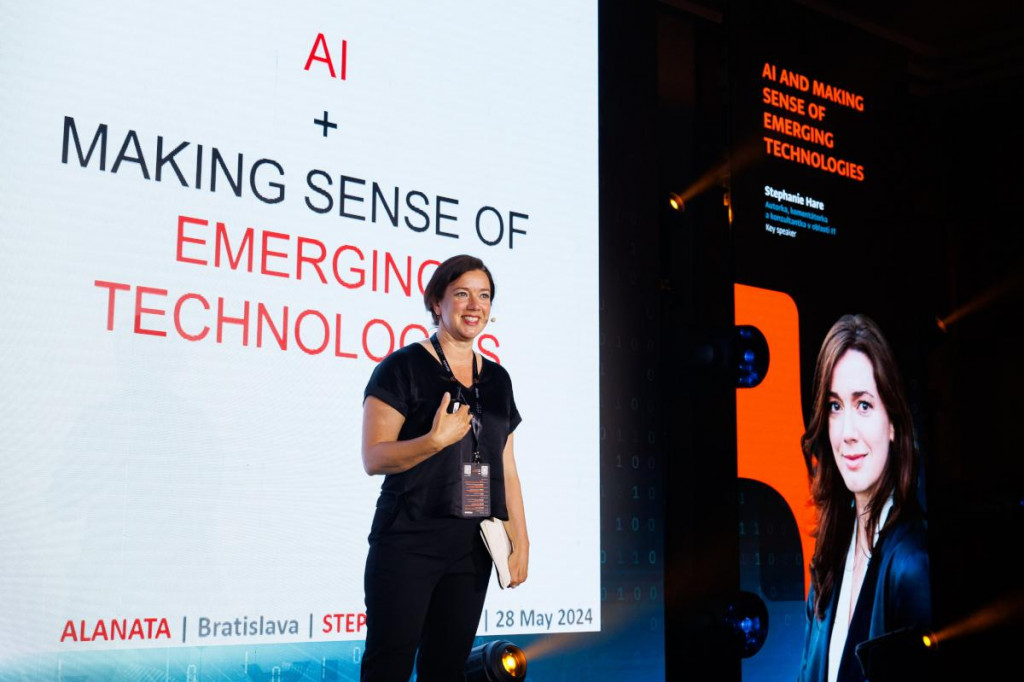

Stephanie Hare často prezentuje v médiách a na konferenciách, ako technológie ovplyvňujú spoločnosť. Vybavená faktmi a príkladmi vysvetľuje, aké etické dilemy pred nami stoja, a odhaľuje tajomstvá technologických gigantov. S rastúcou popularitou umelej inteligencie sa jej pozvania do diskusií hromadia niekoľko mesiacov dopredu.

Risk, hrozba, panika?

Stephanie Hare sa úvodom prednášky sústreďuje na tú lepšiu stránku AI. Úprimne a s presvedčením hovorí o tom, ako môže umelá inteligencia podporovať kreativitu a ľudský potenciál.

Prvé varovanie však prichádza vzápätí. „O kybernetickej bezpečnosti a umelej inteligencii nebudem hovoriť profesionálom. Pozrime sa na používateľov všetkých úrovní, lebo skutočné nebezpečenstvo číha tam.“ A Stephanie ešte raz zdôrazní – najslabšou stránkou kybernetickej bezpečnosti sú ľudia.

Aby sa vytvorilo bezpečné prostredie pre rozvoj umelej inteligencie a ochranu používateľov, profesionáli si vymedzili nielen technické, ale aj etické úlohy.

Vedieť viac

V prvom rade by mali byť produkty a služby s využitím AI jednoznačne označené. Čoraz dôležitejšie bude dbať na bezpečnosť, keď sa produkty na báze AI sprístupňujú verejnosti.

V celom procese musí byť zabezpečená ochrana duševného vlastníctva, súkromia a ľudských práv. Používatelia by mali vedieť, ako AI systém pracuje, aké údaje používa a aké sú jeho rozhodovacie procesy. Na vyššej úrovni to zahŕňa vysvetlenie algoritmov a modelov, ktoré systém používa.

Za rozhodnutia alebo výstupy AI musí byť niekto zodpovedný, či už o vývojárov alebo spoločnosti. A, samozrejme, aj za následky, ktoré z týchto rozhodnutí vyplývajú.

Možnosť „opt-outs from AI systems“ znamená odmietnuť alebo sa odhlásiť z používania aplikácií a služieb založených na umelej inteligencii. Používatelia musia mať možnosť kontrolovať, ako sú ich údaje zbierané, spracovávané a používané AI systémami. A rozhodnúť sa, či chcú byť vôbec do týchto systémov zahrnutí.

Otrava zdrojových dát

Ak budú veľké jazykové modely trénovať na „otrávených“ dátach, respektíve používať dáta tretej strany bez overenia zdrojov, bezpečnostný risk bude rásť. Pritom začlenenie nekvalitných, nepravdivých alebo zavádzajúcich informácií do tréningových dát môže byť úmyselné aj neúmyselné. „Veľké jazykové modely sú iba také dobré, ako sú dobré zdrojové dáta,“ zdôrazňuje Stephanie.

AI modely sú ešte veľmi zraniteľné

Zabezpečenia ochrany systémov strojového učenia sa dá prelomiť. A to aj napriek robustným bezpečnostným opatreniam.

Prompt injection attack spočíva v tom, že útočník manipuluje prompty, čiže dopyty tak, aby model vykonával neúmyselné alebo škodlivé akcie. Tento druh útoku môže mať rôzne formy, ale často sa zameriava na obídenie kontrol a bezpečnostných opatrení v modeloch.

Temné tajomstvá AI

Jedno z najlepšie strážených tajomstiev je ešte stále fakt, akú veľkú environmentálnu záťaž predstavuje používanie umelej inteligencie. Stále neexituje transparentný model, ako merať spotrebu vody či elektrickej energie.

Napríklad AI vyhľadávače spotrebujú 4- až 5-násobne viac energie ako tie klasické. Majú vyššiu výpočtovú náročnosť a infraštruktúrne požiadavky – tréning, prevádzka modelov, rozsiahle datacentrá s chladením a masívna infraštruktúra, čo zabezpečuje dostupnosť pre veľký počet používateľov.

V jednoduchej konverzácii, ktorá má 20 – 50 otázok, GPT-3 „vypije“ pollitrovú fľašu vody. Veľa? Málo? Závisí od krajiny, kde tú vodu spotrebuje. Niektoré zdroje uvádzajú, že keď sa zohľadní energia na prevádzku aj chladenie dátových centier, bežná polhodinová konverzácia s GPT-3 by mohla viesť k spotrebe približne 1,8 litra vody.*

Takže aká je uhlíková stopa AI?

Technologické giganty priznávajú, že presné čísla nevedia, a diplomatická formulácia znie „uhlíková stopa je výrazná“. Rozhodne to zatiaľ nie je technológia, ktorá chráni životné prostredie.

Dátové centrá na tréning a prevádzku veľkých jazykových modelov spotrebujú v súčasnosti dve percentá svetovej energie.

Prevádzkovatelia dátových centier sa bránia, že v skutočnosti vlastne ani nevedia, čo u nich beží, „či sú to LLM modely alebo stream“. Priznávajú, že pri tomto tempe ani nemajú dostatočnú infraštruktúru na prevádzku udržateľnej AI infraštruktúry.

Očakáva sa, že do konca roku 2024 budú dátové centrá, ktoré prevádzkujú AI systémy, zodpovedné za viac ako tretinu zvýšenia globálnej spotreby elektriny.*

Čoraz častejšie sa ozývajú aj hlasy, že každý štát by mal mať na tento účel nezávislý cloud.

Nezabudnuteľné odpovede

Keďže Stephanie Hare sa špecializuje na etické problémy spojené s umelou inteligenciou, slovenské publikum bolo nadšené možnosťou pýtať sa jej priamo po prezentácii. Takže dve najlepšie témy na záver.

Zlomí používanie AI dôveru ľudí v každodenný život, vo voľby v alebo e-banking?

„Áno, je to možné, ak nebudeme o tom hovoriť,“ vysvetľuje Stephanie a ako príklady uvádza banky a osvietené vlády, ktoré investujú do AI aplikácií aj do ochrany.

Sú oblasti, kde by mala byť AI zakázaná?

Opatrní musíme byť vo vzdelávaní, keď sa deti a mladí ľudia učia kritickému mysleniu. Viete si predstaviť, ako ľahko sa stávajú závislými od sociálnych sietí a takisto môžu byť závislými od používania AI aplikácií.

Stephanie Hare je výskumníčka, publicistka a konzultantka v oblasti technológií, trendov a biznisu. Jej silnou stránkou je zrozumiteľná interpretácia poznatkov a prepájanie humanitných vied a technológií.

Skúsenosti a vedomosti zúročila v knihe Technológie nie sú neutrálne: Krátky sprievodca etikou technológií (Technology Is Not Neutral: A Short Guide to Technology Ethics). Za svoj prínos v tejto oblasti získala kniha v roku 2022 uznanie magazínu Financial Times a editori ju zaradili medzi odporúčané čítanie.

Prednáška Stephanie Hare odznela v Bratislave 28. 5. 2024 a v kontexte publicity bola doplnená vysvetleniami a *príkladmi.

Konferencia Judgment Day si zapísala do histórie 17. ročník. Organizátorom bola spoločnosť Alanata.